如今大家每天都会用各种人工智能工具,像是DeepSeek这种有着强大的语言理解和生成能力的大模型,正在成为许多人工作与生活中的“智能助手”。然而,随着线上用户激增,服务器压力大、响应慢等问题也让人头疼。经常用DeepSeek的朋友,应该每天甚至每次都会遇到服务器繁忙的问题,对于多数朋友来说,本地部署性能相对基础的DeepSeek 14B模型,就足以获得一台既高效又安全的“私人AI工作站”了。

在线版的DeepSeek用起来确实方便,性能强大,语言流利,能帮你解答问题、分析数据甚至写代码。但想要让DeepSeek稳定可靠的为我们的工作提供帮助,本地部署的DeepSeek不依赖网络,响应速度更快,还能保护你的隐私数据不被泄露。尤其对于需要频繁使用AI辅助工作的用户,本地部署能充分发挥硬件性能,比如处理复杂任务时减少卡顿,生成结果的速度也能提升一个档次。

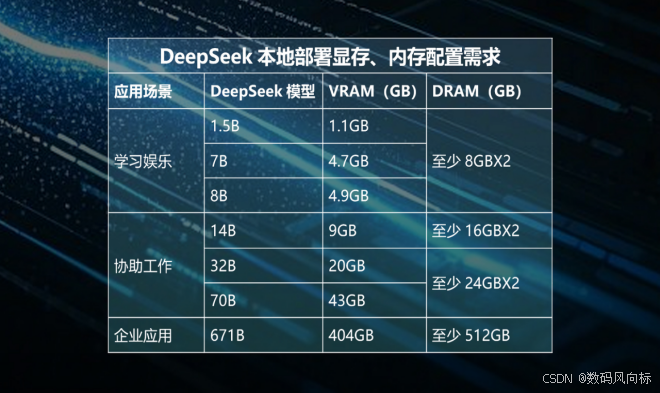

本地部署需要什么样的配置?

相比以往的大模型产品,DeepSeek大大降低了硬件需求门槛,想让基础版本的DeepSeek 14B流畅运行,普通的消费级内存和显卡就足够了,具体来说,在配置上,显存需求上14B模型需要至少9GB显存,推荐搭配像RTX 3060 12GB这样的显卡。它价格亲民,性能足够应对日常办公和轻量级创作,比如写报告、处理表格或简单编程。

至于内存配置,作为AI运行的“工作台”,容量不足会导致系统卡顿甚至崩溃。对于大多数用户,16GB×2(即32GB)的内存组合是性价比之选。比如光威龙武DDR4 16G×2 3600MHz C16,时序低、稳定性强;若追求更高性能,可选DDR5版本16G×2 6400MHz C32,超频后速度提升显著,价格却比国际品牌实惠不少。

我目前用的比较多的时光威内存,它的龙武系列内存不仅支持一键超频,还采用严选颗粒和加厚散热马甲,长时间运行也能保持稳定。比如DDR5版本实测超频至7600MHz后,读写速度提升超20%,多任务处理更加丝滑。

光威作为国产存储品牌的代表,近年来以“高性价比+稳定耐用”赢得了口碑。龙武系列内存尤其适合预算有限但追求性能的用户,相比同规格国际品牌,光威价格低20%-30%,但性能毫不缩水。而且因为用料扎实,所以开启XMP或手动调整参数后,DDR5版本可轻松突破标称频率,提升AI模型的加载和运行效率。此外无论是Intel还是AMD平台,都能稳定适配,装机小白也能轻松上手。

对于普通用户,32GB内存已足够应对DeepSeek 14B和多任务并行;专业用户若需处理更大数据量,可升级至48GB或更高容量,避免“内存焦虑”。

本地部署的隐藏优势

除了速度和隐私,本地部署还能让DeepSeek更“懂你”。通过调整模型参数,比如开启“快速注意力”功能,可以减少生成答案的等待时间;搭配高性能SSD(如致态TiPro9000 PCIe 5.0),模型加载速度甚至能缩短一半。这种“软硬结合”的优化,让AI真正成为提升生产力的工具,而非“玩具”。

如果你希望用最低成本体验AI的高效,不妨从DeepSeek 14B模型起步,搭配光威龙武内存和RTX 3060显卡。这套配置既能满足日常办公、学习需求,又能为未来升级留出空间。技术发展日新月异,但好用的工具始终是“让复杂变简单”,一台入门配置的台式机可能不能打4K的3A大作,但却可以流畅运行本地部署的DeepSeek 14B,成为我们日常工作中值得信赖的伙伴。

今年中国618购物节提前至5月13日鸣锣开市,各大电商平台试图通过拉长战线刺激消费。TechInsights发布的数据显示, 尽管此举带动平台总成交额(GMV)实现增长,但智能手机市场却呈现出复杂图景:销量整体持平,销售额却因零售价格普降而遭遇下滑。

OMEN暗影精灵 11 游戏笔记本(后简称暗影精灵11)可以说是近期关注度比较高的游戏本,硬件规格主流,性能释放不低,关键是价格太香了,国补后RTX 5060版本最低也就6000多一点,RTX 5070版本国补后最低甚至低于7000元,性价比放在一线品牌中十分突出。今天我拿到了暗......

容声冰箱携“寻鲜之旅”养鲜答卷鲜耀南博会!

炎炎夏日,当城市在热浪中喘息,无数家庭的厨房正化身“高温孤岛”。这种困境催生了一个新兴市场:厨房空调。然而,一面是高速增长,一面是家庭渗透率仍不足1%的现实,这款被寄予厚望的产品,究竟是真正的生活刚需,还是企业炒作的精致鸡肋?

日前,多个招聘平台的招聘信息显示,潮玩巨头泡泡玛特正在招募小家电研发工程师、工业设计师等专业人才,月薪在1.5万-2.5万元,岗位职责明确指向复古小冰箱、咖啡机、早餐机的开发流程,甚至要求十年以上家电行业经验。这家以盲盒玩偶风靡全球的企业,正在向一个看似毫不相干的领域伸出触角——......

发动机质量日系遥遥领先,但要说技术还得是德系!

日前,2025高通汽车技术与合作峰会在苏州盛大举行,此次峰会上,高通携手广大主机厂、供应商,展示了骁龙座舱平台至尊版、Snapdragon Ride平台至尊版等汽车平台,以及落地方案,展示了基于舱驾融合理念下的汽车智能新体验

全球高端电视市场的竞争格局,正迎来中韩巨头深度较量的关键时期。一边是以三星、LG为代表的韩国巨头,凭借深厚的显示技术底蕴和品牌积淀强势布局;另一边则是以TCL、海信为首的中国军团,以极具性价比的创新技术与灵活策略发起冲击。这场交锋的核心焦点,已鲜明地聚焦于新型显示技术路线的争夺:......

挂耳式耳机什么牌子好?怎么选?开放式耳机测评推荐

好开 够稳 更聪明 | iCAR V23以全能实力燃爆昆仑决世界格斗冠军赛104

日前,2025高通汽车技术与合作峰会在苏州盛大举行,现场,除了有高通汽车平台硬核展示之外,还云集了汽车领域的诸多大佬,留下了不少精彩瞬间

华为智驾灵魂人物空降,吉利迎来iPhone时刻

在生物柴油上涨的推动下,相关上市公司业绩表现随之修复。

当方盒子遇见摇滚灵魂,iCAR V23以先锋态度助燃苏见信「尽兴而活」成都巡演

智能驾驶当下的发展方向,一个是从L2级别辅助驾驶向L3级别自动驾驶迈进,另一个就是实现算力硬件的自研,比如说小鹏即将在G7上首发上车的自研图灵AI芯片。哪怕是财务状况一直紧张的蔚来,也在不遗余力推动自研神玑NX9031芯片的发展。

“一家在海外市场已经很有知名度的中国电视品牌,利用其现有渠道转做空调,但其净利润率仅为3%。”2025年6月底,深圳“中国企业出海高峰论坛”上,格力电器市场总监朱磊的发言引发关注。

罗姆宣布,与领先的车规芯片企业芯驰科技面向智能座舱联合开发出参考设计“REF68003”。

在新能源汽车技术的激烈角逐中,“打死不做增程” 的呼声背后,是对更优技术方案的探寻。长城汽车的 Hi4 技术应运而生,以破局者之姿,重新定义混动四驱新标准,尤其是在与增程技术的对比中,优势尽显。

强到没朋友,指纹加密+100W快充,这款至高8T硬盘盒颠覆我的体验

森萨塔的 SIM200 绝缘监测设备可检测高压电气系统(如EV充电)中的潜在隔离故障以帮助确保系统安全运行