恰逢今年是理想汽车成立的第10年,也是AI的大风口下;在2025年5月7日,理想AI Talk第二季正式开播,这一期的主讲内容是:理想VLA司机大模型,从动物进化到人类。理想汽车董事长兼CEO李想重点分享了对于人工智能的最新思考,VLA司机大模型的作用、训练方法和挑战,以及对于创业和个人成长的见解。

在聊这个话题之前呢,我们先来聊一下什么是什么是规则算法、什么是端到端,以及最近最火的VLA,因为很多人都不知道。

首先规则算法简单理解就是按照软件工程师输入的规则去运行,在一些没有规则覆盖的极端情况下,因为缺乏对应的规则程序,就容易不知所措了。运行链路:感知-规划-控制,感知模块包含了感知和预测。

端到端指的是感知端和控制端,也就是输入端和输出结果端,通过神经网络替代了感知和规划这两大模块,神经网络大模型根据感知和预测直接输出控制结果,进行对应的车辆减速转弯等操作,不再根据给定的规则走,也不依赖地图,逻辑像人。其中的重点就是学习驾驶这件事情,因此大模型需要进行大量的场景数据训练,可能还会存在一些无法识别的场景,运行中很难和人类进行沟通,除了直接接管。

端到端+VLA司机大模型,VLA就是Vision-Language-Action Model的缩写,中文全称为视觉语言行动模型。就像最近很火的AI语言大模型,VLA可以根据司机输入的语言文字图片视频等信息,让车辆理解场景,具备思考能力,判断能力以及相应执行能力,做一个AI司机。

李想对AI工具的理解

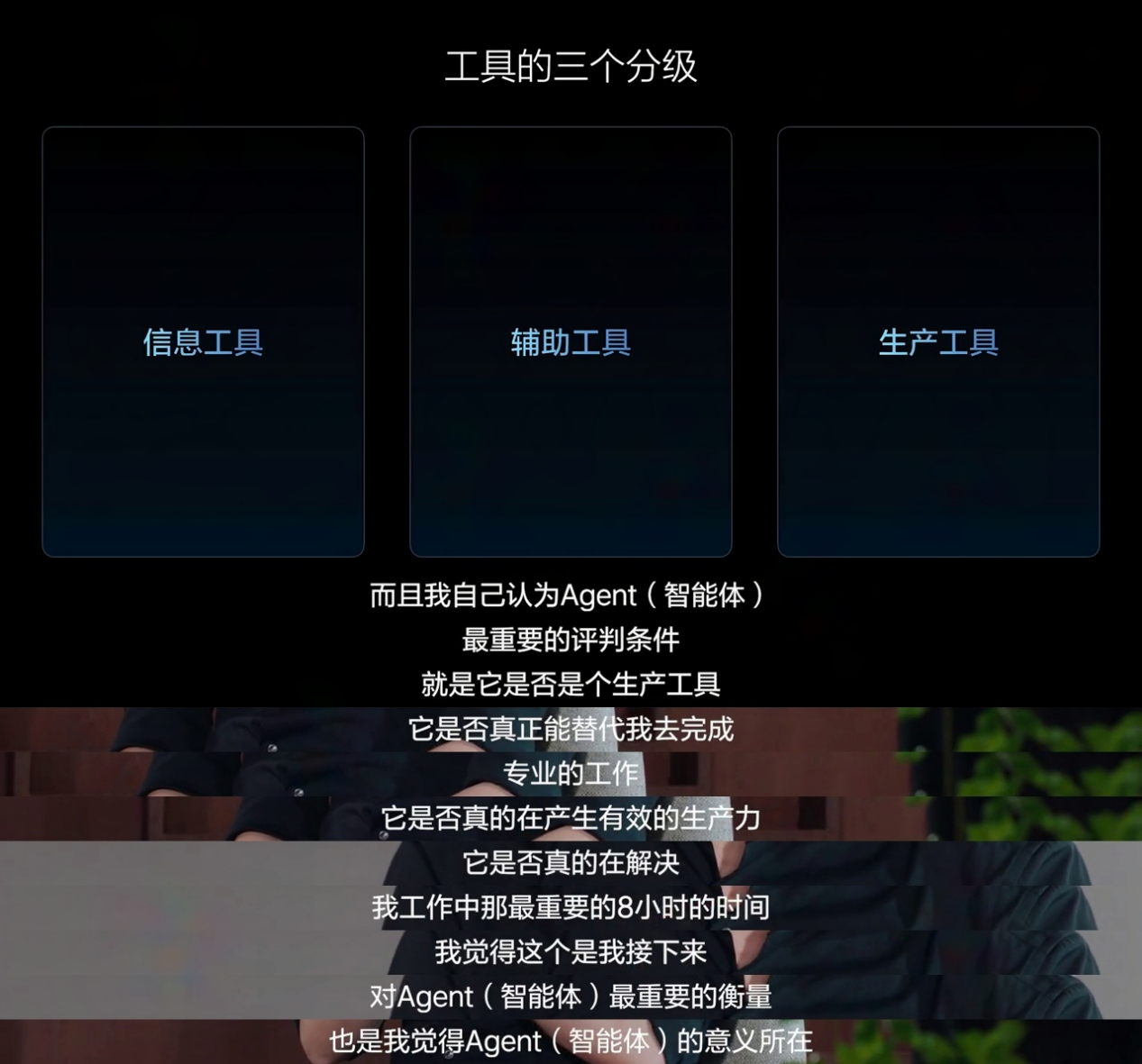

当前李想将AI工具分为三个层级,分别是信息工具、辅助工具和生产工具。目前,大多数人将AI作为信息工具使用,但信息工具常伴随大量无效信息、无效结果和无效结论,仅具参考价值。成为辅助工具后,AI可以提升效率,例如现在的辅助驾驶,但仍需人类参与。未来,AI发展为生产工具后,将能独立完成专业任务,显著提升效率与质量。

李想表示:“判断Agent(智能体)是否真正智能,关键在于它是否成为生产工具。只有当人工智能变成生产工具,才是其真正爆发的时刻。就像人类会雇佣司机,人工智能技术最终也会承担类似职责,成为真正的生产工具。”

VLA-向人类司机一样工作的司机大模型

目前的L2、L2+组合驾驶辅助仍属于辅助工具阶段,而VLA(Vision-Language-Action Model,视觉语言行动模型)能够让AI真正成为司机,成为交通领域的专业生产工具。对理想汽车而言, 未来的VLA就是一个像人类司机一样工作的司机大模型”。

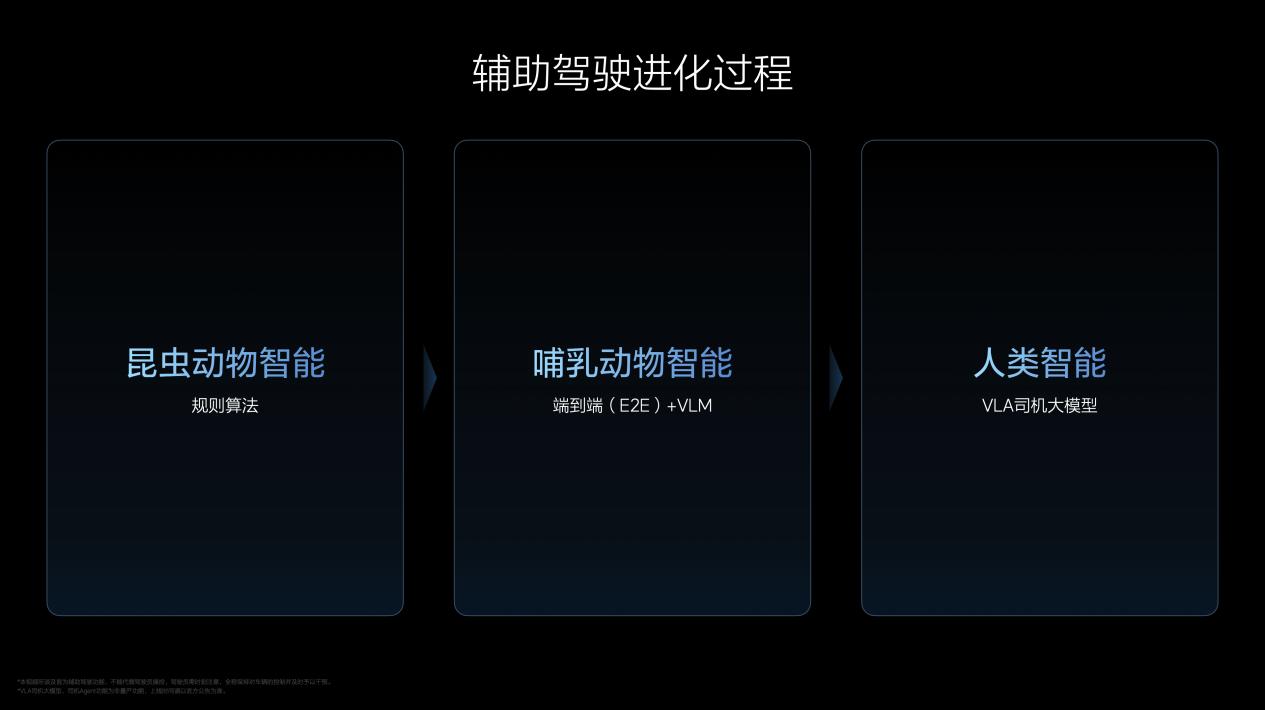

VLA的实现不是一个突变的过程,是进化的过程,经历了三个阶段,对应理想汽车辅助驾驶的昨天、今天和明天。第一阶段,理想汽车自2021年起自研依赖规则算法和高精地图的辅助驾驶,类似“昆虫动物智能”。第二阶段,理想汽车自2023年起研究,并于2024年正式推送的端到端+VLM(Vision Language Model,视觉语言模型)辅助驾驶,接近“哺乳动物智能”。

端到端模型在处理复杂问题时存在局限,虽可借助VLM视觉语言模型辅助,但VLM使用开源模型,使其在交通领域的能力有限。同时端到端模型也难以与人类沟通。为了解决这些问题并提升用户的智能体验,理想汽车自2024年起开展VLA研究,并在多项顶级学术会议上发表论文,夯实了理论基础。

在端到端的基础上,到第三阶段,VLA将开启“人类智能”的阶段。它能通过3D和2D视觉的组合,完整地看到物理世界,而不像VLM仅能解析2D图像。同时,VLA拥有完整的脑系统,具备语言、CoT(Chain of Thought,思维链)推理能力,既能看,也能理解并真正执行行动,符合人类的运作方式。

VLA训练过程模拟人类学习,对齐人类价值观

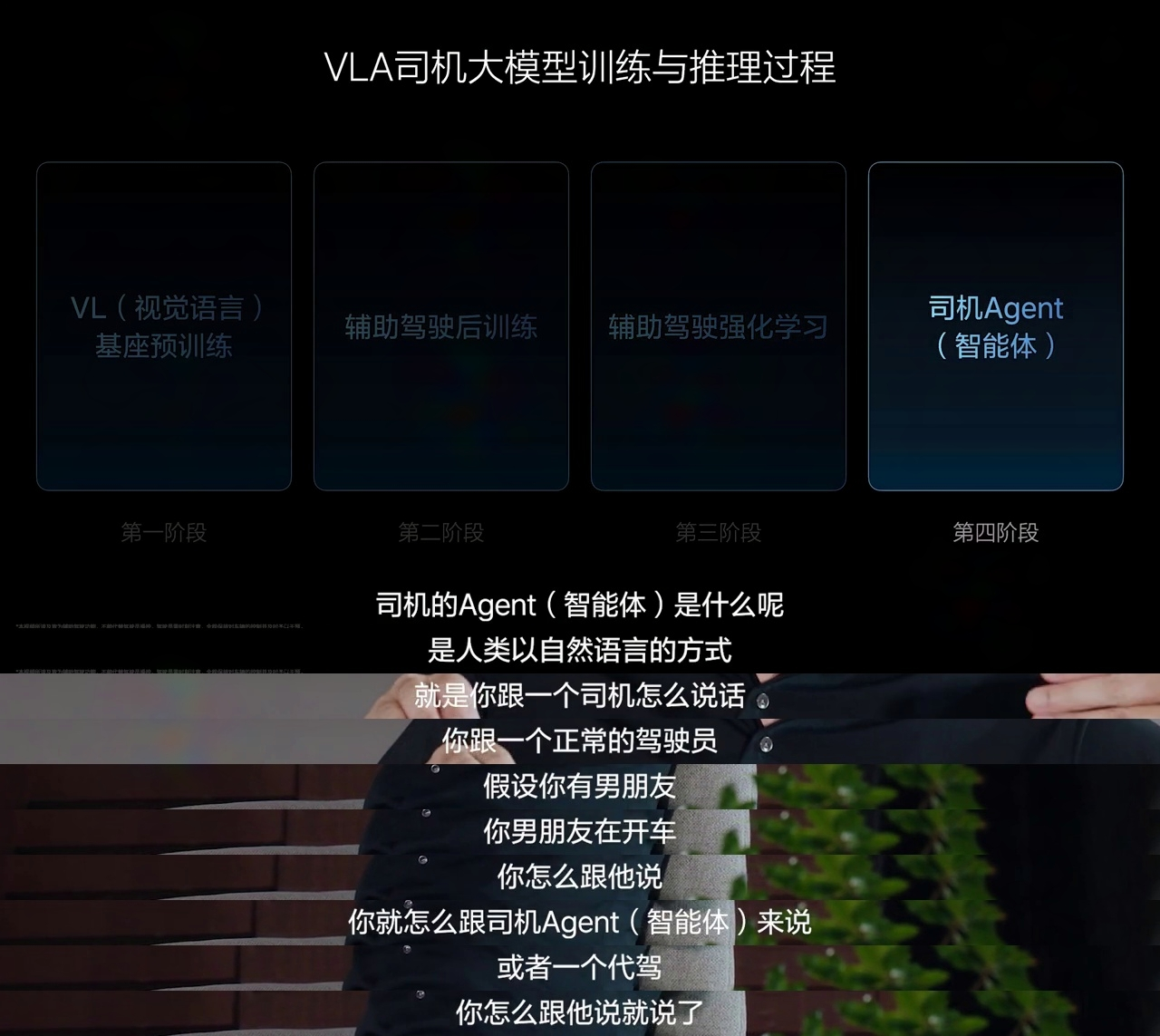

VLA的训练分为预训练、后训练和强化训练三个环节,类似于人类学习驾驶技能的过程。预训练相当于人类学习物理世界和交通领域的常识,通过大量高清2D和3D Vision(视觉)数据、交通相关的Language(语言)语料,以及与物理世界相关的VL(Vision-Language,视觉和语言)联合数据,训练出云端的VL基座模型,并通过蒸馏转化为在车端高效运行的端侧模型。

后训练相当于人类去驾校学习开车的过程。随着Action(动作)数据的加入——即对周围环境和自车驾驶行为的编码,VL基座变为VLA司机大模型。得益于短链条的CoT,以及Diffusion扩散模型对于他车轨迹和环境的预测,VLA具备实时性的特点,实现了在复杂交通环境中的博弈能力。

强化训练类似于人类在社会中实际开车练习,目标是让VLA司机大模型更加安全、舒适,对齐人类价值观,甚至超越人类驾驶水平。强化训练包含两部分:一是通过RLHF(Reinforcement Learning from Human Feedback,基于人类反馈的强化学习)完成安全对齐,使模型遵守交通规则,贴合中国用户的驾驶习惯;二是将纯强化学习模型放入世界模型中训练,提升舒适性,避免碰撞事故,遵守交通规则。经过预训练、后训练和强化训练后,VLA司机大模型即可部署至车端运行。

VLA司机大模型以“司机Agent(智能体)”的产品形态呈现,用户可通过自然语言与司机Agent沟通,跟人类司机怎么说,就跟司机Agent怎么说。简单通用的短指令由端侧的VLA直接处理,复杂指令则先由云端的VL基座模型解析,再交由VLA处理。

超级对齐确保AI决策安全,世界模型破解AI黑盒难题

除了提升专业能力,VLA司机大模型还需解决安全性和模型黑盒的问题。

模型能力越强,越需要职业性约束,以确保能力下限。为了保障VLA司机大模型能够实现职业司机般的安全和舒适,避免学习加塞等违规行为,理想汽车在强化训练环节投入大量资源,并于2024年底组建超过100人的超级对齐团队,相当于为司机Agent注入职业素养。

为解决模型的黑盒问题,理想汽车结合重建和生成两种路径,打造了真实、符合物理世界规律的世界模型,覆盖所有交通参与者和要素。基于世界模型的仿真能力,VLA可以在世界模型中低成本、准确地验证现实问题,提升解决问题的效率,有效应对模型黑盒带来的挑战。

判断司机Agent是否是个好司机,有三个关键标准:专业能力、职业能力和构建信任的能力。VLA司机大模型提升了专业能力,超级对齐增强了职业能力,VLA通过理解自然语言、具备记忆能力提升了构建信任的能力。

李想:大型企业的基本功和能力永远无法被逾越

在辅助驾驶方面,由于英伟达Orin-X芯片无法直接运行语言模型,端到端+VLM的辅助驾驶方案对部分企业来说仍具挑战。理想汽车依托自有编译团队,自研底层推理引擎,使芯片可通过INT4(4比特整型)量化的方式运行VLM。同时,凭借芯片、控制器设计和自研汽车操作系统等综合能力,理想汽车实现了让双Orin-X芯片和Thor-U芯片运行同等规模的VLA司机大模型。得益于DeepSeek的开源,理想汽车在VLA司机大模型的语言能力研发上提速显著,节省了近9个月的时间和数亿元成本。尽管如此,理想汽车仍选择加大投入,在基座模型上投入超预期3倍的训练卡,专注打造适配多场景的自研模型。李想表示:“我们可以站在巨人的肩膀上,但它只是其中的一部分。”在受益开源的同时,理想汽车也选择开源自研的汽车操作系统——理想星环OS,回馈社会。

在如今这个时间节点,各种智能化的配置,以及可以营造出来的大车才有的体量感,这些似乎都成为了市场的主流趋势。当然了,面对新能源车的快速发展,这些类似的产品也确实给很多消费者留下了深刻的印象,那就是跟智能手机一样可玩性很高,同时也足够省油、安静。

因为最近我准备买辆代步车,所以便了解了一下最近一段时间国内汽车市场的销量排行榜单,赫然发现吉利银河星愿这款代步小车占据着销冠宝座。五月份的销量成绩将近四万台,甚至比很多车型一年的累计销量都要多,将小米SU7、特斯拉等众多竞争对手比下去。看到这样的排行榜,我不禁十分好奇,这台代步小......

这年头消费者的生活水平提高了,但是经济收入普遍呈现下滑趋势,所以消费者在购车的时候,往往也希望用实惠的价格买到高品质车型。今天我们来聊长安启源A05,这款车型的官方定位是插混动力紧凑型车,不过它的车身数据足够优秀,实际上已经达到A+级别车型的主流水平。更关键的是,长安启源A05虽......

2025优选!分分快3的所有计划平台攻略(最新指南)

动力还要降低?零跑B01再推低功率版,好消息是价格肯定继续降低

自律成就自由:快3计划平台攻略

当“带电”的混动系统遇上硬派皮卡,你猜猜会擦出怎样的火花?

新能源时代来临之后,很多消费者一门心思冲着“零油耗出行”选择新能源车型,但是依旧有一些传统燃油车型受消费者喜爱。前段时间,我家巷子就有一位小年轻选购了吉利旗下的紧凑型SUV博越L,本来我并不了解这款车,但在见到实车之后,也深深喜欢上了它。有一说一,如今2025款博越L的官方起售价......

在新能源汽车技术不断发展的当下,市面上众多新能源车型得到消费者喜爱,很多人都说,如今是新能源汽车的时代。不过与新能源车型相比,传统燃油车型依旧有补能快的优势,很多消费者购车的时候,依旧喜欢优先考虑传统燃油车。今天我们就来聊一款性价比很高的燃油车,它就是定位紧凑型SUV的博越L。

2025乐选!分分快3公式技巧

小米YU7价格公布后,发布会结束后3分钟内,YU7订单已经超过20万台,1小时大定突破289000台。这样的热度引发热议,很多人讨论,这里很多有黄牛和转单的成分,最直观的方式,可以去线下门店了解销售情况。

在中国年度车主办的“全球新一代新能源技术分享会”上,吉利汽车系统性地展示了其在新能源技术领域的最新研发成果与战略思考。全面进化的雷神AI电混2.0技术平台,以及将安全标准推向新高度的神盾金砖电池,更清晰地勾勒出吉利在人工智能时代,以“AI赋能”与“安全筑基”为双轮驱动,意图引领全......

纽北路试被拍!全新奥迪Q3 Sportback动力覆盖燃油+插混

小米YU7一小时订单近30万 岂是一句粉丝经济就能解释的?

进入到2025年,在汽车行业激烈竞争下,上汽作为行业多年的龙头标杆,仍持续保持汽车产业的长线思维,既彰显了上汽集团董事长王晓秋和总裁贾健旭的成熟理性,也展示了作为一个传统造车大厂的底层思考框架和坚实底蕴。 显然,战略是企业发展的指南针和航标,在波诡云谲的市场环境下,底层思考更......

星纪元ES增程以亲民价重塑豪华车格局

奇瑞瑞虎8两款新车型上市 售价10.69万起

2025乐选组!快3的计划玩法篇

2025年6 月 26 日晚,奇瑞风云旗下备受瞩目的中大型轿车 —— 风云 A9L 正式开启预售。此次预售共推出 4 款车型,价格区间为 15.99 - 22.99 万元,凭借极具吸引力的价格与丰富配置,一登场便赚足眼球。